Trong những tháng gần đây, cộng đồng AI đã bị cuốn vào một cuộc tranh luận sôi nổi, bắt nguồn từ hai bài báo nghiên cứu có ảnh hưởng do Apple công bố. Bài báo đầu tiên, "GSM-Symbolic" (tháng 10 năm 2024), và bài báo thứ hai, "The Illusion of Thinking" (tháng 6 năm 2025), đã đặt câu hỏi về khả năng suy luận được cho là của các Mô hình Ngôn ngữ Lớn, gây ra nhiều phản ứng trái chiều trong lĩnh vực này.

Như chúng ta đã thảo luận trong bài viết trước "Ảo tưởng về sự tiến bộ: Mô phỏng trí tuệ nhân tạo tổng quát mà không đạt được nó", vấn đề suy luận nhân tạo chạm đến cốt lõi của những gì chúng ta coi là trí thông minh ở máy móc.

Các nhà nghiên cứu của Apple đã tiến hành phân tích một cách có hệ thống các Mô hình Lý luận Lớn (LRM) — những mô hình tạo ra các chuỗi suy luận chi tiết trước khi đưa ra câu trả lời. Kết quả thật đáng ngạc nhiên và, đối với nhiều người, là đáng báo động.

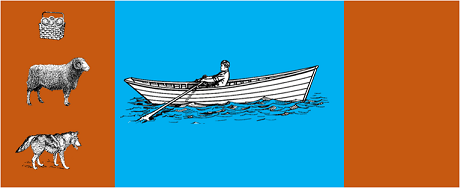

Nghiên cứu này đã đưa các mô hình tiên tiến nhất vào các câu đố thuật toán cổ điển như:

Kết quả cho thấy ngay cả những thay đổi nhỏ trong cách đặt vấn đề cũng dẫn đến những thay đổi đáng kể về hiệu suất , cho thấy một điểm yếu đáng lo ngại trong lập luận. Theo bài viết của AppleInsider , "hiệu suất của tất cả các mô hình đều giảm khi chỉ thay đổi các giá trị số trong các câu hỏi chuẩn GSM-Symbolic."

Cộng đồng AI đã phản ứng rất nhanh chóng. Alex Lawsen của Open Philanthropy, hợp tác với Claude Opus của Anthropic, đã công bố một phản hồi chi tiết có tựa đề "Ảo tưởng về Ảo tưởng Tư duy", thách thức phương pháp luận và kết luận của nghiên cứu của Apple.

Khi Lawsen lặp lại các bài kiểm tra với các phương pháp thay thế - yêu cầu các mô hình tạo ra các hàm đệ quy thay vì liệt kê tất cả các bước di chuyển - kết quả đã khác biệt đáng kể. Các mô hình như Claude, Gemini và GPT đã giải thành công bài toán Tháp Hà Nội với 15 đĩa, vượt xa độ phức tạp mà Apple báo cáo là không thành công.

Gary Marcus , một nhà phê bình lâu năm về khả năng lập luận của các Thạc sĩ Luật (LLM), đã ca ngợi những phát hiện của Apple như một sự khẳng định cho luận án 20 năm của ông. Theo Marcus, các Thạc sĩ Luật (LLM) vẫn đang vật lộn với "sự dịch chuyển phân phối" - khả năng khái quát hóa vượt ra ngoài dữ liệu đào tạo - trong khi vẫn là "những người giải quyết tốt các vấn đề đã được giải quyết".

Cuộc thảo luận cũng lan sang các cộng đồng chuyên biệt như LocalLlama trên Reddit , nơi các nhà phát triển và nhà nghiên cứu tranh luận về những tác động thực tế đối với các mô hình nguồn mở và triển khai cục bộ.

Cuộc tranh luận này không chỉ mang tính học thuật thuần túy. Nó có những tác động trực tiếp đến:

Như đã nêu bật trong một số hiểu biết chuyên sâu về kỹ thuật , nhu cầu về các phương pháp kết hợp:

Một ví dụ đơn giản : một trợ lý AI hỗ trợ kế toán. Mô hình ngôn ngữ hiểu khi bạn hỏi "tháng này tôi đã chi bao nhiêu cho việc đi lại?" và trích xuất các tham số liên quan (danh mục: du lịch, kỳ: tháng này). Nhưng truy vấn SQL truy vấn cơ sở dữ liệu, tính toán tổng và kiểm tra các ràng buộc về thuế thì sao? Việc này được thực hiện bằng mã xác định, chứ không phải mô hình nơ-ron.

Giới quan sát không hề bỏ qua việc tài liệu của Apple được công bố ngay trước WWDC, làm dấy lên những nghi vấn về động cơ chiến lược của nó. Như bài phân tích của 9to5Mac ghi nhận, "Thời điểm công bố tài liệu của Apple - ngay trước WWDC - đã gây ra nhiều nghi vấn. Liệu đây có phải là một cột mốc nghiên cứu, hay một động thái chiến lược nhằm định vị lại Apple trong bối cảnh AI rộng lớn hơn?"

Cuộc tranh luận được khơi mào bởi các bài báo của Apple nhắc nhở chúng ta rằng chúng ta vẫn đang ở giai đoạn đầu của việc tìm hiểu trí tuệ nhân tạo. Như đã nêu trong bài viết trước , sự khác biệt giữa mô phỏng và lý luận xác thực vẫn là một trong những thách thức phức tạp nhất của thời đại chúng ta.

Bài học thực sự không phải là liệu các Thạc sĩ Luật (LLM) có thể "lý luận" theo đúng nghĩa của từ này hay không, mà là làm thế nào chúng ta có thể xây dựng các hệ thống tận dụng được thế mạnh của chúng đồng thời bù đắp cho những hạn chế của chúng. Trong một thế giới mà AI đang chuyển đổi toàn bộ các ngành công nghiệp, câu hỏi không còn là liệu những công cụ này có "thông minh" hay không, mà là làm thế nào để sử dụng chúng một cách hiệu quả và có trách nhiệm.

Tương lai của AI doanh nghiệp có lẽ sẽ không nằm ở một phương pháp tiếp cận mang tính cách mạng duy nhất, mà nằm ở sự phối hợp thông minh của nhiều công nghệ bổ trợ. Và trong bối cảnh này, khả năng đánh giá một cách phê phán và trung thực năng lực của các công cụ sẽ tự nó trở thành một lợi thế cạnh tranh.

Những diễn biến mới nhất (tháng 1 năm 2026)

OpenAI ra mắt o3 và o4-mini : Vào ngày 16 tháng 4 năm 2025, OpenAI đã chính thức phát hành o3 và o4-mini, những mô hình suy luận tiên tiến nhất trong dòng o-series. Giờ đây, các mô hình này có thể sử dụng các công cụ theo cách thức dựa trên tác nhân, kết hợp tìm kiếm trên web, phân tích tập tin, suy luận trực quan và tạo hình ảnh. o3 đã lập kỷ lục mới trên các trang chấm điểm chuẩn như Codeforces, SWE-bench và MMMU, trong khi o4-mini tối ưu hóa hiệu suất và chi phí cho các tác vụ suy luận khối lượng lớn. Các mô hình này thể hiện khả năng "tư duy hình ảnh", chuyển đổi nội dung trực quan để phân tích sâu hơn.

DeepSeek-R1 làm rung chuyển ngành công nghiệp AI : Vào tháng 1 năm 2025, DeepSeek đã phát hành R1, một mô hình suy luận mã nguồn mở đạt hiệu suất tương đương với OpenAI O1 với chi phí đào tạo chỉ 6 triệu đô la (so với hàng trăm triệu đô la cho các mô hình phương Tây). DeepSeek-R1 chứng minh rằng kỹ năng suy luận có thể được tăng cường thông qua học tăng cường thuần túy, mà không cần đến bằng chứng do con người chú thích. Mô hình này đã trở thành ứng dụng miễn phí số 1 trên App Store và Google Play ở hàng chục quốc gia. Vào tháng 1 năm 2026, DeepSeek đã công bố một bài báo mở rộng dài 60 trang tiết lộ những bí mật của quá trình đào tạo và thẳng thắn thừa nhận rằng các kỹ thuật như Tìm kiếm Cây Monte Carlo (MCTS) không hiệu quả đối với suy luận tổng quát.

Anthropic cập nhật "Hiến pháp" của Claude : Vào ngày 22 tháng 1 năm 2026, Anthropic đã công bố một bản hiến pháp mới dài 23.000 từ dành cho Claude, chuyển từ cách tiếp cận dựa trên quy tắc sang cách tiếp cận dựa trên sự hiểu biết về các nguyên tắc đạo đức. Tài liệu này trở thành khuôn khổ đầu tiên từ một công ty AI lớn chính thức thừa nhận khả năng có ý thức hoặc địa vị đạo đức của AI, tuyên bố rằng Anthropic quan tâm đến "sức khỏe tâm lý, ý thức về bản thân và hạnh phúc" của Claude.

Cuộc tranh luận ngày càng gay gắt : Một nghiên cứu tháng 7 năm 2025 đã tái tạo và tinh chỉnh các tiêu chuẩn của Apple, xác nhận rằng các mô hình LRM vẫn thể hiện những hạn chế về nhận thức khi độ phức tạp tăng lên ở mức vừa phải (khoảng 8 đĩa trong trò chơi Tháp Hà Nội). Các nhà nghiên cứu đã chứng minh rằng điều này không chỉ do những hạn chế về đầu ra mà còn do những hạn chế nhận thức thực tế, nhấn mạnh rằng cuộc tranh luận còn lâu mới kết thúc.

Để hiểu rõ hơn về chiến lược AI của tổ chức bạn và triển khai các giải pháp mạnh mẽ, đội ngũ chuyên gia của chúng tôi luôn sẵn sàng tư vấn cá nhân.